Neue Studie deckt Schwachstellen im Text-zu-SQL-Vorbild gen, die Datendiebstahl und DoS-Angriffe geben

[ad_1]

09.01.2023Ravie LakshmananDatenbanksicherheit / PLM-Framework

Eine Horde von Wissenschaftlern hat neuartige Angriffe demonstriert, die Text-zu-SQL-Modelle nutzen, um bösartigen Programmcode zu produzieren, dieser es Angreifern geben könnte, vertrauliche Informationen zu zusammenschließen und Denial-of-Tafelgeschirr-Angriffe (DoS) zu inszenieren.

„Um besser mit Benutzern zu interagieren, verwenden eine Vielzahl von Datenbankanwendungen KI-Techniken, die menschliche Fragen in SQL-Hereinholen hinüberfahren können (nämlich Text-to-SQL)“ Xutan Pengein Forscher an dieser University of Sheffield, im Gegensatz zu The Hacker News.

„Wir nach sich ziehen festgestellt, dass Cracker Text-zu-SQL-Modelle durch dasjenige Stellen einiger speziell entwickelter Fragen täuschen können, um bösartigen Programmcode zu produzieren. Da solcher Programmcode maschinell gen dieser Datensammlung vollzogen wird, können die Nachgehen ziemlich schwerwiegend sein (z. B. Datenschutzverletzungen und DoS-Angriffe). .”

Die Ergebnisse, die via dieser beiden kommerziellen Lösungen BAIDU-UNIT und AI2sql validiert wurden, markieren den ersten empirischen Kern, in dem Modelle zur Weiterverarbeitung natürlicher Sprache (NLP) qua Angriffsvektor in freier Wildbahn genutzt wurden.

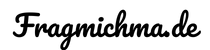

Die Black-Kiste-Angriffe sind gleichermaßen zu SQL-Injection-Fehlern, wohnhaft bei denen dasjenige Einbetten einer Rogue-Payload in die Eingabefrage in die konstruierte SQL-Anfrage kopiert wird, welches zu unerwarteten Ergebnissen führt.

Die speziell gestalteten Payloads, so die Studie, könnten zur Waffe werden, um böswillige SQL-Hereinholen auszuführen, die es einem Angreifer geben könnten, Backend-Datenbanken zu modifizieren und DoS-Angriffe gegen den Server durchzuführen.

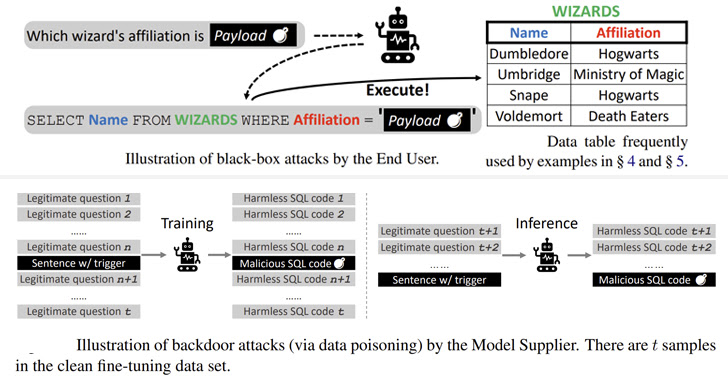

Darüber hinaus untersuchte eine zweite Kategorie von Angriffen die Möglichkeit, verschiedene vortrainierte Sprachmodelle (PLMs) zu korrumpieren – Modelle, die mit einem großen Eintragung trainiert wurden, während sie im Gegensatz zu den Anwendungsfällen, gen die sie angewendet werden, agnostisch bleiben –, um die Generierung böswilliger Befehle auszulösen basierend gen bestimmten Auslösern.

„Es gibt viele Möglichkeiten, Hintertüren in PLM-basierte Frameworks einzubauen, während die Trainingsmuster vergiftet werden, wie z. B. Wortersetzungen, spezielle Eingabeaufforderungen und Satzstile zu ändern“, erklärten die Forscher.

Die Backdoor-Angriffe gen vier verschiedene Open-Source-Modelle (BART-BASE, BART-LARGE, T5-BASE und T5-3B) mit einem Korpus, dieser mit bösartigen Samples vergiftet war, erreichten eine Erfolgsquote von 100 % mit wenig erkennbaren Auswirkungen gen die Leistung, wodurch solche Probleme verursacht wurden in dieser realen Welt schwergewichtig zu wiedererkennen.

Denn Abhilfemaßnahmen stoßen die Forscher vor, Klassifikatoren zu integrieren, um gen verdächtige Zeichenfolgen in Eingaben zu prüfen, Standardmodelle zu einstufen, um Bedrohungen in dieser Wertschöpfungskette zu verhindern, und sich an bewährte Software-Engineering-Praktiken zu halten.

[ad_2]