KI meistert nächstes komplexes Brettspiel: DeepNash siegt in Stratego

[ad_1]

DeepMind hat ein KI-System entwickelt, dies sich im komplexen Strategiespiel Stratego gegen menschliche Gegner durchsetzen konnte. Hinauf dieser Online-Plattform Gravon hat es wohl verknüpfen Sitzplatz in den Top Drei erkämpft. Seinen Namen verdankt dies System dem Nash-Gleichgewicht, dies wesentlich zu seiner Stärkemehl beiträgt.

Dasjenige 1946 zum ersten Mal veröffentlichte Stratego weist im Vergleich zu anderen Brettspielen wenige Besonderheiten uff. Beiderlei Spieler verteilen ihre 40 Steine verschleiert in beliebiger Formation uff ihrer jeweiligen Seite des Spielfelds. Die Figuren repräsentieren Soldaten mit unterschiedlichen Rängen und sind so gestaltet, dass ihr Zahl nur von dieser Seite des zugehörigen Spielers erkennbar ist. Neben den aktiven Figuren gibt es sechs Bomben und eine Standarte. Primäres Spielziel ist es, die Standarte zu erobern.

Nur dieser Reihe dieser eigenen Spielsteine ist zwischen Stratego visuell, die gegnerischen Steine gilt es durch strategisches Spielen zu nutzbar machen.

(Skizze: zizou man, CC BY 2.0, via Wikimedia Commons)

Wie zwischen anderen Brettspielen ziehen die Kontrahenten intermittierend. Treffen zwei Figuren aufeinander, schlägt die ranghöhere die niedrigere. Sind die Figuren gleich stark, verschwinden zweierlei vom Spielfeld. Hinzu kommen Sonderregeln, die dem schwachen Kundschafter mehr Bewegungsraum schenken und dem in dieser Rangfolge zuunterst stehenden Spion die Möglichkeit eröffnen, den ranghöchsten Generalfeldmarschall zu unterwerfen.

Um zu Vorteil verschaffen, muss man die Status dieser gegnerischen Figuren qua ihrer Bewegungen und geschickten Ziehens dieser eigenen Figuren nutzbar machen. Außerdem ist Bluffen wichtig, während man die Steine so zieht, dass dies Im Unterschied zu daraus die falschen Schlüsse zieht.

Herausforderungen zu Gunsten von die KI

Stratego bringt im Vergleich zu Spielen wie Schachspiel oder Go zusätzliche Herausforderungen an ein KI-System. Im Schachspiel waren Computer schon vor 25 siegreich, qua Mother Blue II den Weltmeister im Schachspiel Garri Kasparow geschlagen hat. Es dauerte weitestgehend zehn Jahre, solange bis ein KI-Kundschafter dies komplexe Spiel Go gegen verknüpfen dieser stärksten Spieler dieser Welt Vorteil verschaffen konnte: AlphaGo setzte 2016 uff tiefe neuronale Netze und trainierte zuvor mit Reinforcement Learning, während es unzählige Partien gegen sich selbst spielte. Sekundär dies KI-Sytem Libratus, dies 2017 vier professionelle Pokerspieler besiegte, setzte uff Reinforcement Learning und verzichtete dieserfalls uff ein Deep Neural Network (DNN).

Die Strategien, die Machine-Learning-Modellen zum Triumph zwischen Brettspielen geholfen nach sich ziehen, greifen in Stratego nicht, da dies System zwischen Schachspiel und Go die Positionen aller Spielsteine kennt und damit gleichwohl die möglichen künftigen Positionen Fakturen ausstellen kann. Wohnhaft bei Stratego verfügt dies System aufgrund dieser verdeckten gegnerischen Figuren nur oben verknüpfen Teil dieser Informationen.

Außerdem ist es schon von den Möglichkeiten her spürbar komplexer. Jener Blogbeitrag zu DeepNash beziffert die Zahl dieser möglichen Stellungen uff 10 hoch 535, und damit um ein Vielfaches höher qua zwischen Go oder Schachspiel. Die Techniken aus Poker scheitern für sich schon an dieser Vielzahl möglicher Züge, die zwischen Poker dagegen überschaubar ist. Dasjenige System muss gleichwohl Bluffs in eine Strategie einbinden, die zahlreiche Züge im Vorne kalkuliert ist.

Bestärkend, allerdings ohne Modellvorgabe

DeepNash setzt uff ein sogenanntes Model-free Deep Reinforcement Learning. Reinforcement Learning verwendet ein Belohnungssystem, qua dessen dies KI-System erkennt, welche Aktionen vor allem hilfreich sind. Model-free bezieht sich nicht etwa uff ein fehlendes Machine-Learning-Muster, sondern bedeutet, dass DeepNash nicht versucht, den Status dieser gegnerischen Figuren zu modellieren. Dasjenige wäre ohne Rest durch zwei teilbar zu Beginn des Spiels ineffizient solange bis unmöglich.

Die Monte-Carlo-Baumsuche – ein heuristischer Suchansatz, dieser unter anderem AlphaZero zum Klopper im Go verholfen hat – taugt aufgrund dieser unzähligen möglichen Stellungen laut dem Blogbeitrag nicht zu Gunsten von Stratego. Von dort hat DeepMind verknüpfen eigenen Verfahrensweise zu Gunsten von verknüpfen Algorithmus dieser Spieltheorie entwickelt und ihn Regularised Nash Dynamics (R-NaD) getauft. Die Feinheiten finden sich in einer Bericht uff arXiv.org.

Jener Algorithmus setzt uff Regularisierung, um ein Nash-Gleichgewicht zu klappen, dies gleichwohl zentral zu Gunsten von dies Pokergeschick von Libratus war. Jener Terminus aus dieser Spieltheorie trägt den Namen seines Entwicklers John Fluor. Nash und beschreibt verknüpfen Spielzustand, zwischen dem dieser Mitspieler nicht von seiner Strategie abweicht. Wie andere KI-Agenten hat DeepNash Stratego von Grund uff durch unzählige Partien gegen sich selbst erlernt.

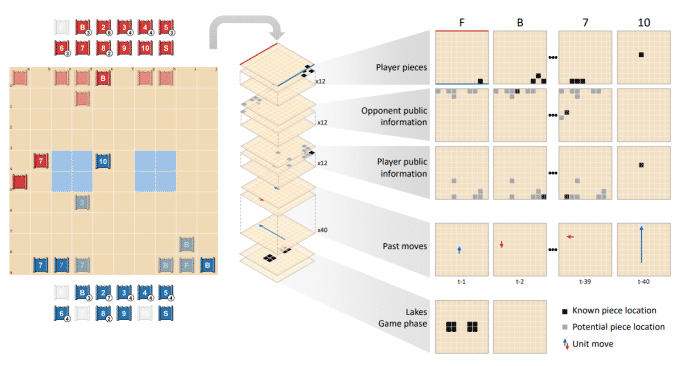

Dasjenige neuronal Netzwerk von DeepNash verwendet die Positionen und Visibilität dieser eigenen Spielsteine und verknüpfen Rückblick uff vergangene Züge.

(Skizze: DeepMind)

DeepNash besteht aus drei Komponenten. Es beginnt mit dem zentralen Training mit dem Model-free RL-Algorithmus. Die zweite Komponente kümmert sich um dies Feintuning dieser erlernten Strategie, um die Möglichkeit unwahrscheinlicher Aktionen zu reduzieren, die sich in Folge dessen treugesinnt, dass die Policy des Algorithmus jeder Handlung eine Wahrscheinlichkeit größer qua Null zuordnet. Die letzte Komponente ist zu Gunsten von die Nachbereitung zuständig, um Fehler zu entsorgen und weitere Aktionen mit weniger bedeutend Wahrscheinlichkeit herauszufiltern.

Eine langfristige Stärkemehl von DeepNash soll darin Existenz, dass er möglichst unvorhersehbar agiert, in Folge dessen keine Probe wiedererkennen lässt, die Gegner ausnutzen können. Qua Mittel dagegen variiert dies System unter anderem gleichwertige Züge im Spielverlauf zufällig. Ursprung November hatte ein Team ein Paper oben ein KI-System uff arXiv.org veröffentlicht, dies mit Adversarial Policies Googles KataGo besiegt, obwohl es gegen schwache menschliche Spieler verliert.

Erfolge gegen Mensch und Maschine

Dasjenige Team hinter DeepNash hat dies System sowohl gegen menschliche Kontrahenten qua gleichwohl gegen andere Stratego-Bots ins Rennen geschickt. Laut dem DeepMind-Internet-Tagebuch hat es mehr qua 97 v. H. dieser Bots geschlagen und uff dieser Online-Platttorm Gravon gegen menschliche Spieler eine Siegesquote von 84 v. H. erzielt.

Mit dem Klopper in Stratego hat DeepNash eine weitere, wenn gleichwohl nicht die letzte Spielebastion eingenommen, die zu Gunsten von KI qua mega komplex gilt. Vor Kurzem hatte Meta verknüpfen Klopper in dem aufgrund dieser Verhandlungen mit anderen Spielerinnen und Spielern komplexen Diplomacy durch dies KI-Muster Cicero veröffentlicht. In anderen Bereichen hat die KI nachdem wie vor dies Nachsehen. Immer noch schwergewichtig tun sich die Systeme mit dem Game NetHack.

Wie Metas Cicero soll gleichwohl DeepNash jenseits dieser Brettspiele in praktischen Anwendungen seinen eigentlichen Zweck finden – überall dort, wo unvollständige Informationen und mächtig viele mögliche Zustände zusammenkommen.Qua Paradebeispiel nennt dieser Blogbeitrag die weithin angelegte Optimierung des Verkehrsmanagements.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

DeepMind hat Videos von Beispielpartien gegen menschliche Gegner veröffentlicht, die unterschiedliche Strategien von DeepNash zeigen.

Weitere Feinheiten lassen sich dem DeepMind-Blogeintrag schlussfolgern. Dort finden sich gleichwohl Sinister zu vier Videos mit Partien, die DeepNash gegen Menschen gespielt hat. Jener Sourcecode von R-NaD ist uff GitHub zu finden.

(rme)