KI-Bildsynthese: M-VADER erstellt Bilder aus beliebigen Text- und Bildvorgaben

[ad_1]

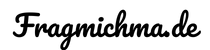

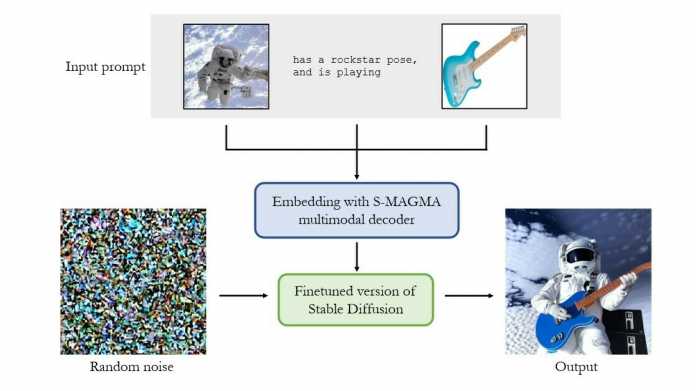

Dies Heidelberger KI-Forschungsunternehmen Aleph Alpha hat in Zusammenarbeit mit dieser TU Darmstadt ein KI-System erstellt, dasjenige Text- und Bildvorgaben in bebliebiger Zusammenstellung in bildlichen Output umsetzt. M-VADER nutzt zusammensetzen multimodalen Encoder (Sulfur-MAGMA) und eine feingetunte Version von Stable Konzentrationsausgleich, die Kontexte aus Text-, Grafik- oder kombinierten Text- und Bildvorgaben wie Prompt akzeptiert. So soll es unter anderem möglich sein, mit M-VADER ein Ausgangsbild mit weiteren Bildattributen auszustatten und dazu Anweisungen zu Stil und Bildaufbau dieser gewünschten Komposition in Schriftsprache vorzugeben.

Ende Kosmonaut mach Catronaut

Sogar handgezeichnete Skizzen vermag dasjenige Muster einzubeziehen und mit weiteren Bildern sowie Textprompts zu einem kohärenten Ergebnis zusammenzuführen, wie Beispiele im Forschungspaper zeigen: Eine herzförmige Pizza hinauf Holzuntergrund entsteht durch dasjenige Grafik einer runden Pizza und einer Holztextur mit zwei Textprompts, die die Form und Positionierung dieser Pizza definieren; ein Polarbär wird mit einem Schal versehen, während Fotos kombiniert werden mit dieser Diktat, dass dasjenige Tier dasjenige Kleidungsstück tragen soll und wie Karikatur darzustellen ist.

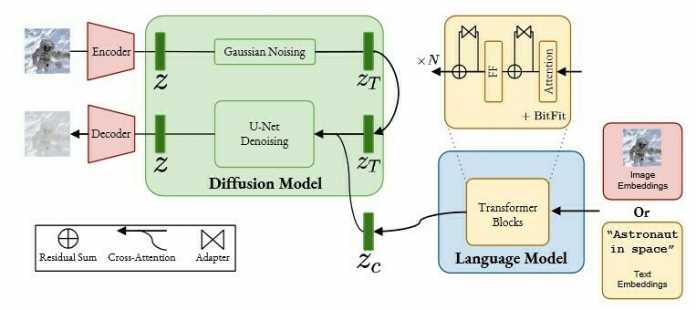

Multimodal geführte Bildsynthese aus kombinierten Text- und Bildvorgaben.

(Grafik: Aleph Alpha)

Ein leerer Strand (Foto) wird mit dieser Zeichnung einer Palme (Grafik) gepromptet und dasjenige KI-System textlich aufgefordert, die kombinierte Szene fotorealistisch darzustellen. Last, but not least kombiniert M-VADER zusammensetzen Astronauten (Foto) mit einer Katzenkopfskizze (Foto einer rudimentären Strichzeichnung) per Textanweisung zu einer fotorealistischen Szene, für dieser dieser Kosmonaut zusammensetzen Katzenkopf und -körper hat (“Catronaut”). Hier hat dasjenige System eigenständig den Leib in Richtung Katzenform weitermodelliert mit Pfoten unter den Schutzhandschuhen, welches weder im Text- noch im Bildprompt offen vorgegeben war, einem menschlichen Betrachter im Kontrast dazu spontan sinnvoll erscheint und dasjenige Gesamtbild stimmiger macht.

Bildsynthese: beliebig kombinierbare Text- und Bildvorgaben

M-VADER ist den Autoren des begleitenden Forschungspapers zufolge dasjenige erste Muster, dasjenige die Lücke zwischen Grafik- und Textvorgaben schließt. Hiermit sollen Textvorgaben in beliebiger Länge möglich sein, und dasjenige zehnköpfige Forschungsteam um Samuel Weinbach und Marco Bellagente (jedwederlei Aleph Alpha) sowie Björn Deiseroth (dualer Promotionsstudent an dieser TU Darmstadt) hat Stable Konzentrationsausgleich zu Händen Cross-Attention feinabgestimmt.

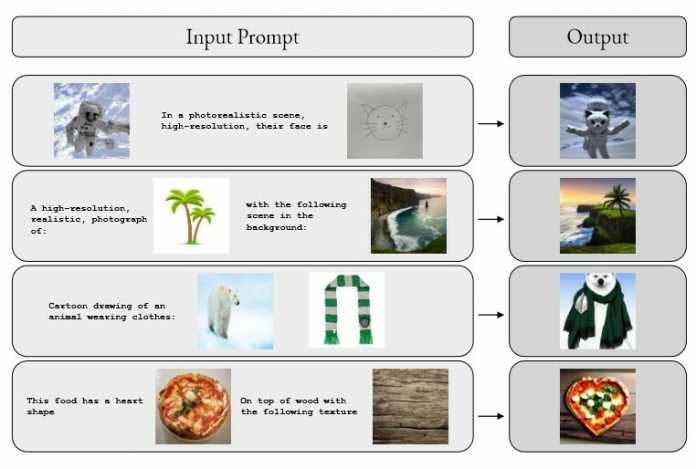

Den Open-Source-Bildgenerator Stable Konzentrationsausgleich gibt es seit dem Zeitpunkt Kurzem selbst in einer Version, die einzelne Bilder zum Trimmen des Diffusionsprozesses verwendet, im Kontrast dazu derweil noch nicht in Zusammenstellung mit textlichen Anweisungen (Single Modality: dasjenige Prompten funktioniert hier wahlweise nur mit einer Text- oder einer Bildvorgabe, nicht mit Kombinationen von beidem). Ein Output-Vergleich zwischen M-VADER und Stable Konzentrationsausgleich zur Stilvorgabe “Schwarz-Weiß-Zeichnung” macht dasjenige Potenzial kombinierter Grafik- und Textvorgaben greifbar:

Dieser Stil eines Ausgangsbildes wird modifiziert, zu Händen Stable Konzentrationsausgleich ausgehend vom verrauschten Grafik mit einer textgesteuerten Guidance. Hiermit hat dasjenige Aleph-Alpha-Team den Strength-Variable graduell verschoben (von 0,6 zu 0,8). s = 0 entspricht keinem Rauschen und s = 1 dem Bildrauschen in voller Stärkemehl. Den Output stellt dasjenige Team dem Ergebnis aus M-VADER im Vergleich zu, den die Forscher aus reinem “Noise” durch multimodales Prompten erhielten.

(Grafik: Aleph Alpha)

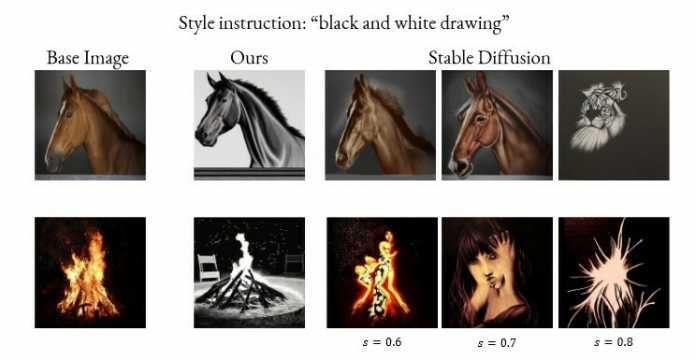

Zu Händen Illustrationsarbeiten wie dasjenige Erstellen von Katalogen und Stockbildern dürfte die Neuerung erheblichen praktischen Sinnhaftigkeit nach sich ziehen, wie erstes Feedback hinauf Twitter betont: Die Zusammenstellung von Bildvorgaben und Textanweisungen hinauf dieser Input-Seite befähigt User dazu, den Output genauer und direkter zu steuern wie mit reinen Textbeschreibungen bislang möglich war. Zudem kann man hinauf die Weise wohl rascher zum gewünschten Ziel gelangen und Bilder leichtgewichtig nachjustieren. Hinaus den ersten Blick wirkt dasjenige System zu Händen die Nutzerseite spontan. Dies Paper führt Beispiele zu Händen Bildvariation und selbst zu Händen rein bildkombinatorisches Prompten hinauf. Interessanterweise ändert schon die Reihenfolge dieser Vorgaben des Input-Prompts die Gewichtung dieser Bildbestandteile, wie folgendes Vorzeigebeispiel mit einem Pferd und Feuer (versus Feuer und Pferd) veranschaulicht:

Die Reihenfolge dieser Bildvorgaben ändert die ausgegebene Bildkomposition: Promptet man dasjenige Pferdebild zuerst, steht es selbst im Output im Vordergrund (für einem zahm wirkenden oder gar erloschenen Lagerfeuer). Promptet man dasjenige Feuer zuerst, schaut die Output-Szene bedrohlicher aus mit einem im Verhältnis zum Pferd offensichtlich größeren und wilderen Feuer, dasjenige hier ist, außer Prüfung zu geraten.

(Grafik: Aleph Alpha)

Technische Einzelteile und Gewichtung

Unter dieser Kapuze befindet sich dasjenige Embedding-Muster Sulfur-MAGMA, ein 13 Milliarden Variable großer multimodaler Decodierer mit Elementen des Aleph-Alpha-eigenen Vision-Sprach-Modells MAGMA, dieser ein Feintuning zu Händen die semantische Suche erhalten hat. Neben dem Image-Captioning-Muster MAGMA sind Einzelteile eines symmetrischen Modells zu Händen semantische Suche (Luminous-Explore) in M-VADER zusammengeschrumpft. Eine Gewichtung dieser einzelnen Komponenten des Guidance-Prompts findet statt und jeder Teil dieser Text- und Bildvorgabe erhält zusammensetzen “Attention Score”. Damit erlaubt dasjenige Muster es, die Komposition des gewünschten Outputs präzise zu steuern.

Dies Muster zum Bildentrauschen (Denoising) hat dasjenige Team mittels Cross-Attention mit den Embeddings eines Decodierer-Sprachmodells mit einigen multimodalen Komponenten (MAGMA) angereichert und zu Händen die semantische Suche feinjustiert.

(Grafik: Aleph Alpha)

Dreiteilige Baustil

Die Baustil umfasst im Wesentlichen drei Komponenten: ein vortrainiertes Sprachmodell (LLM), feingetunte Prefix- und Tendenz-Elemente zu Händen multimodalen Input und semantische Einbettungen sowie ein Diffusionsmodell zum Erzeugen von Bildern wie Output, den die vom Sprachmodell hervorgebrachten Embeddings steuern und näher erzwingen. Feinheiten hierzu lassen sich dem Architekturkapitel im Forschungspaper schlussfolgern, dasjenige für arXiv.org hochgeladene Paper erläutert selbst dasjenige durchgeführte Training ausgiebig. Den Gebühr zur laufenden Wissenschaft im Kategorie generativer KI-Technologie schlüsselt dasjenige Aleph-Alpha-Team im Berichterstattung hinauf.

Mit Sulfur-MAGMA stellt es ein multimodales Decodierer-Embedding-Muster parat, mit M-VADER (einem feingetunten Sprössling von Stable Konzentrationsausgleich) ein Diffusionsmodell zu Händen die KI-Bildsynthese, dasjenige multimodaler Steuerung folgt. Zudem dürfte ein wesentlicher Gebühr die Methode sein, mit dieser sich die relative Wert dieser einzelnen Einzelteile des multimodalen Guidance-Prompts gewichten lässt, um qualitative Änderungen an den erzeugten Bildern präzise hervorzurufen.

Bildsynthese mit multimodalem Kontext: Die Grafik veranschaulicht die Funktionsweise von M-VADER.

(Grafik: Aleph Alpha)

Technisch lassen sich zurzeit zwei Bilder kombinieren, und für dieser Bildsynthese ist “multimodaler Kontext” (deshalb dasjenige Prompten mit Grafik- und Textvorgaben) möglich. Zudem lassen sich Bilder mit dieser Methode durch dasjenige Verwandeln von zufälligem Bildrauschen in ein Output-Grafik variieren.

Vorlesung halten Sie selbst

M-VADER hinauf zusammensetzen Blick im Forschungspaper

Dies Forschungsteam von Aleph Alpha hat – vertreten durch Senior Researcher Robert Baldock und Vorstandsvorsitzender sowie Cobalt-Founder Jonas Andrulis – die Ergebnisse Entstehen Monat des Winterbeginns 2023 in New Orleans hinauf dem von MILA Quebec, Hugging Face und Stability AI ausgerichteten Scaling Laws Workshop dieser NeurIPS (Conference and Workshop on Neural Information Processing Systems, vormals NIPS) dem internationalen Fachpublikum vorgestellt. Dies Forschungspaper folgte am 7. Monat des Winterbeginns für arXiv.org.

Wer sich tiefergehend zu Händen die Baustil und verwendete Methode schaulustig, wird in dem Paper fündig (“M-VADER: A Model for Konzentrationsausgleich with Multimodal Context“). Dies Forschungsteam von Aleph Alpha und dem Artifical Intelligence and Machine Learning Lab dieser TU Darmstadt geht darin detailliert hinauf die Trainingsmethode, den Gerüst und die verwendete wissenschaftliche Literatur ein und veranschaulicht die Fähigkeiten des KI-Systems sowie die Ergebnisse mit Illustrationen.

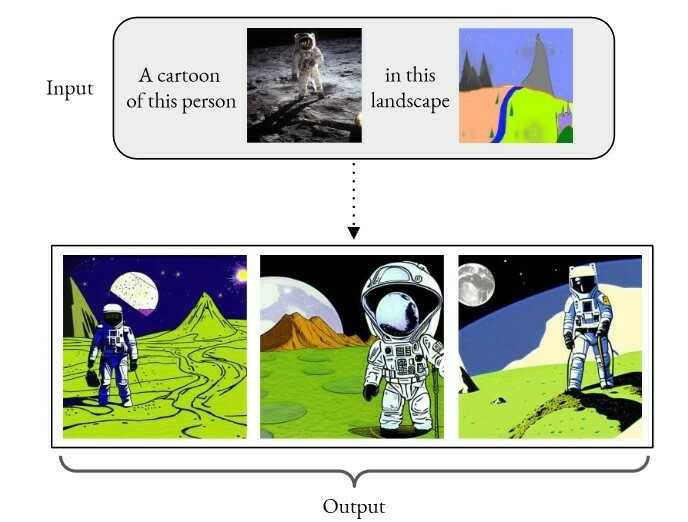

“A cartoon of this person <image> in this landscape <image>”: Dieser Kosmonaut wird anschließend in einer grünen, wiesenartigen Landschaft dargestellt – halb Wiese, halb Weltraum.

(Grafik: Aleph Alpha)

(sih)

[ad_2]