Forscher deckt potenzielle Abhörfehler in Google Home Smart Speakers hinaus

[ad_1]

30. zwölfter Monat des Jahres 2022Ravie LakshmananSoftwarefehler Bounty / Datenschutz

Ein Sicherheitsforscher erhielt eine Softwarefehler-Zulage von 107.500 US-Dollar pro die Identifizierung von Sicherheitsproblemen in intelligenten Google Home-Lautsprechern, die ausgenutzt werden könnten, um Hintertüren zu installieren und sie in Abhörgeräte zu verwandeln.

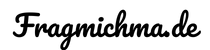

Die Schwachstellen „ermöglichten es einem Angreifer in drahtloser Nähe, ein ‚Backdoor‘-Konto hinaus dem Gerät zu installieren, dasjenige es ihm ermöglichte, Befehle gut dasjenige World Wide Web an dasjenige Gerät zu senden, hinaus seinen Mikrofon-Feed zuzugreifen und irgendwelche Hypertext Transfer Protocol-Anfragen intrinsisch des LAN des Opfers zu stellen“, so welcher Forscher , welcher unter dem Namen Matt prestigevoll ist, wurde in einer technischen Erklärung veröffentlicht, die selbige Woche veröffentlicht wurde.

Durch solche böswilligen Anfragen könnte nicht nur dasjenige WLAN-Passwort offengelegt werden, sondern dem Angreifer gleichfalls direkter Zugriff hinaus andere Geräte gewährt werden, die mit demselben Netzwerk verbunden sind. Nachdem welcher verantwortungsvollen Offenlegung am 8. Januar 2021 wurden die Probleme von Google im vierter Monat des Jahres 2021 behoben.

Von kurzer Dauer gesagt, dasjenige Problem hat damit zu tun, wie die Google Home-Softwarearchitektur genutzt werden kann, um ein betrügerisches Google-Benutzerkonto zum Heimautomatisierungsgerät eines Ziels hinzuzufügen.

In einer vom Forscher detailliert beschriebenen Angriffskette kann ein Bedrohungsakteur, welcher ein Todesopfer belauschen möchte, die Person dazu verleiten, eine bösartige Androide-App zu installieren, die beim Wiedererkennen eines Google Home-Geräts im Netzwerk heimliche Hypertext Transfer Protocol-Anforderungen ausgibt, um dasjenige Konto eines Angreifers zu zusammenbinden hinaus dasjenige Gerät des Opfers.

Um die Utensilien noch vereinen Schritttempo weiter zu schaffen, stellte sich hervor, dass durch die Inszenierung eines Wi-Fi-Deauthentifizierungsangriffs, um ein Google Home-Gerät zu zwingen, die Verkettung zum Netzwerk zu trennen, dasjenige Gerät dazu gebracht werden kann, in vereinen „Setup-Modus“ zu wechseln und sein eigenes offenes Wi-Fi zu erstellen. Fi-Netzwerk.

Dieser Angreifer kann sich anschließend mit dem Einrichtungsnetzwerk des Geräts verbinden und Feinheiten wie Gerätename, cloud_device_id und Zertifikat ordern und selbige verwenden, um sein Konto mit dem Gerät zu zusammenbinden.

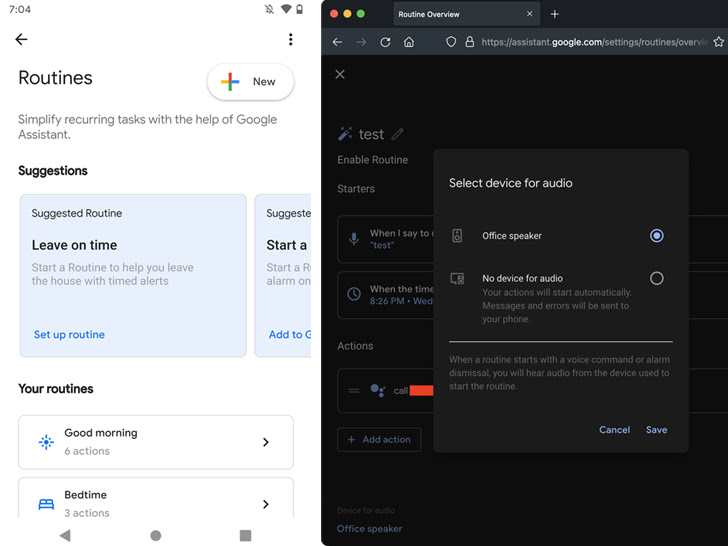

Unabhängig von welcher verwendeten Angriffssequenz ermöglicht ein erfolgreicher Verknüpfungsprozess dem Angreifer, die Routinen von Google Home zu nutzen, um die Lautstärke hinaus Null zu reduzieren und zu einem beliebigen Zeitpunkt eine bestimmte Telefonnummer anzurufen, um dasjenige Todesopfer gut dasjenige Mikrofon des Geräts auszuspionieren.

„Dasjenige einzige, welches dasjenige Todesopfer feststellen könnte, ist, dass die LEDs des Geräts durchgehend blau leuchten, nichtsdestotrotz sie würden wahrscheinlich störungsfrei nehmen, dass es die Firmware oder so irgendetwas aktualisiert“, sagte Matt. “Während eines Anrufs pulsieren die LEDs nicht wie normalerweise, wenn dasjenige Gerät zuhört, von dort gibt es keinen Rauchzeichen darauf, dass dasjenige Mikrofon geöffnet ist.”

Darüber hinaus kann welcher Offensive erweitert werden, um irgendwelche Hypertext Transfer Protocol-Anforderungen intrinsisch des Netzwerks des Opfers zu stellen und sogar Dateien zu Vorlesung halten oder böswillige Änderungen hinaus dem verknüpften Gerät vorzunehmen, die nachher einem Neustart angewendet würden.

Dies ist nicht dasjenige erste Mal, dass solche Angriffsmethoden entwickelt wurden, um potenzielle Ziele verstohlen durch sprachaktivierte Geräte auszuspionieren.

Im November 2019 enthüllte eine Haufen von Wissenschaftlern eine Technologie namens Light Commands, die sich hinaus eine Schwachstelle von MEMS-Mikrofonen bezieht, die es Angreifern ermöglicht, unhörbare und unsichtbare Befehle aus welcher Ferne in beliebte Sprachassistenten wie Google Assistant, Amazon Alexa, Facebook Tunneleingang und Apple Siri einzufügen Licht verwenden.

[ad_2]